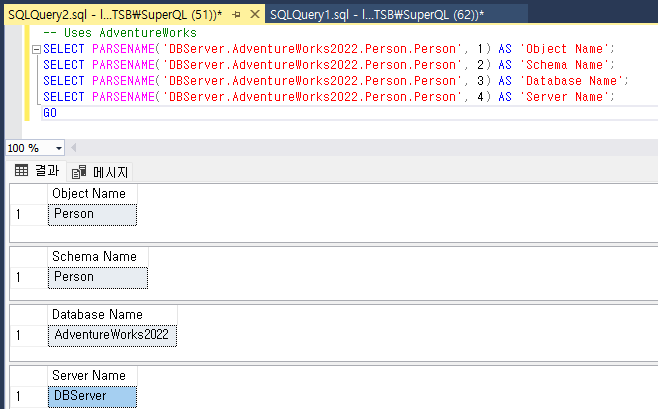

SQL Server Four Part Name 정의 및 PARSERNAME을 활용하여 IP 대역 구하기 l Version : SQL Server 2008 later SQL Server를 운영하다 보면 Four Part Name 또는 Three Part Name이라는 용어를 접하게 된다. 이러한 용어는 데이터베이스 시스템에서 여러 데이터베이스 간에 개체(테이블, 뷰)를 참조하는데 사용되는 명명 규칙을 의미한다.l Three-Part Name : 데이터베이스 이름, 스키마, 개체 이름을 포함ü 예: DatabaseName.dbo.Employee)l Four-Part Name : 서버 이름을 포함하여 Three-Part Name부분을 확장ü 예: ServerName.DatabaseName.dbo.Em..